La catena di fornitura del software è l'infrastruttura fondamentale della società moderna e la sua protezione è cruciale. Questa filiera comprende un grande numero di progetti e strumenti open source: circa il 97% delle applicazioni contiene codice open source, il che rende la sicurezza della supply chain del software ancora più importante.

Possono aiutare in questa impresa gli strumenti di intelligenza artificiale, come ChatGPT e altri modelli linguistici di grandi dimensioni: questi tool possono infatti contribuire a identificare e gestire le vulnerabilità del software, applicare patch e raccogliere informazioni in tempo reale.

Individuare le vulnerabilità

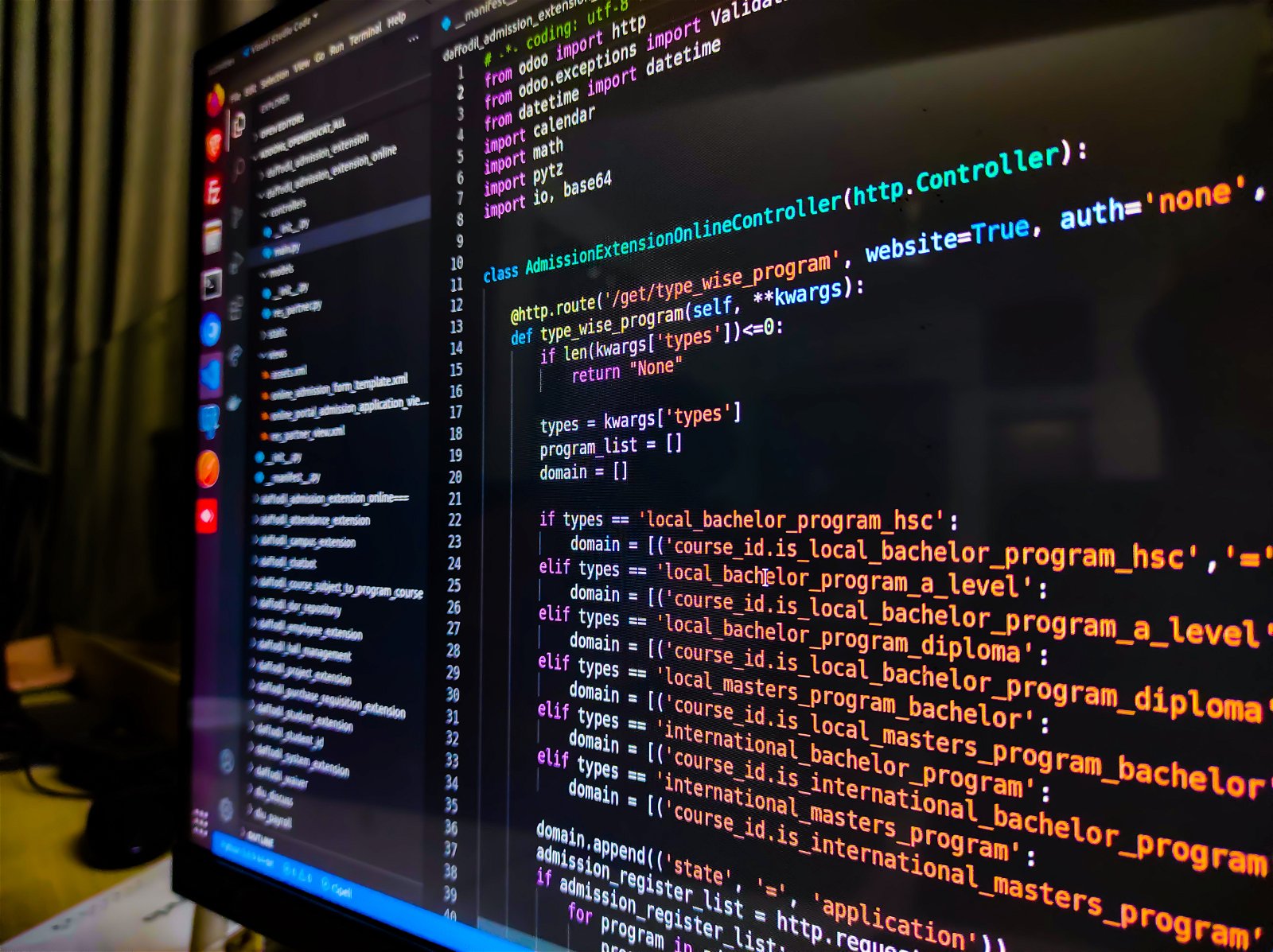

L'intelligenza artificiale può essere utilizzata per identificare più rapidamente e con precisione le vulnerabilità nel codice open source, grazie a strumenti come DroidGPT e l'uso di tecniche di apprendimento non supervisionato come gli autoencoder o le vector machine.

Gli strumenti possono scansionare il codice alla ricerca di vulnerabilità su larga scala e imparare a identificarne di nuove man mano che emergono, insieme all'aiuto dei supervisori umani.

Questo processo automatizzato è utile per identificare problemi di sicurezza comuni come overflow del buffer e attacchi di iniezione che possono essere sfruttati dai criminali informatici.

Inoltre, l'automazione può accelerare il testing e identificare rapidamente i problemi in produzione, consentendo alle organizzazioni di evitare costose multe e danni alla reputazione monitorando la conformità tramite l'uso di algoritmi che analizzano i dati.

L'intelligenza artificiale può essere utilizzata per correggere le vulnerabilità nel codice open source automatizzando il processo di identificazione e applicazione di patch. Inoltre, l’IA può educare gli sviluppatori sulle migliori pratiche di sicurezza, aiutandoli a scrivere codice più sicuro e mitigare le vulnerabilità.

GPT come supporto per la sicurezza

Gli strumenti AI dei Large Language Model possono consigliare le migliori pratiche agli sviluppatori in tempo reale se addestrati su repository sicuri e rivisti, eliminando la necessità di rilevare e correggere le vulnerabilità in una richiesta automatica pull/merge (PR/MR).

I modelli di linguaggio di grandi dimensioni, come GPT-4 e ChatGPT, possono aiutare a testare la sicurezza dei progetti open source e produrre risultati di alta qualità, suggerendo modifiche e correzioni per migliorare la sicurezza del codice.

L'automazione può avvenire anche lato utente, integrando il flusso di lavoro del LLM in un progetto. Gli sviluppatori possono chiedere a ChatGPT di analizzare il codice e identificare eventuali difetti. Sebbene gli LLM non siano perfetti, possono essere utili per ridurre il numero di vulnerabilità in un progetto open source del 80%.