OpenAI ha annunciato ufficialmente GPT-4, la nuova release del suo celebre modello di generazione di testi.

Il Generative Pre-trained Transformer (GPT-4) è la quarta iterazione del modello sviluppato da OpenAI. GPT-4 è una rete neurale che, come i suoi predecessori, è stata pre-addestrata su un grande volume di dati testuali per produrre un linguaggio simile a quello umano.

GPT-4 è disponibile da subito per gli abbonati al servizio premium ChatGPT Plus (con un limite di utilizzo), mentre gli sviluppatori possono iscriversi a una lista d’attesa per accedere all'API.

Il prezzo è di 0,03 dollari Usa per 1.000 token prompt e 0,06 per 1.000 token completion (in entrambi i casi pari a circa 750 parole). I token prompt sono le parti di parole inviate come input a GPT-4, mentre i token di completamento rappresentano il contenuto generato dal modello.

Chi non volesse spendere denaro per toccare con mano il nuovo modello, può rivolgersi al nuovo motore di ricerca conversazionale di Microsoft: l’azienda ha infatti confermato che Bing Chat utilizza fin dal suo debutto ufficiale una versione ottimizzata del nuovo modello di OpenAI.

Le novità principali

GPT-4 può accettare come input anche immagini e ha dimostrato competenze di “livello umano” in vari benchmark professionali e accademici; questi successi in realtà dicono molto anche sulla struttura quasi esclusivamente nozionistica di molti esami.

OpenAI ha trascorso sei mesi “allineando iterativamente” GPT-4, ottenendo migliori risultati su fattualità, guidabilità e rifiuto di uscire dai vincoli imposti. Come i precedenti modelli di questa famiglia, anche GPT-4 è stato addestrato utilizzando dati disponibili pubblicamente e informazioni concessi in licenza a OpenAI.

Nel post che ha accompagnato l’annuncio del nuovo modello, OpenAI ha dichiarato: “In una conversazione casuale, la distinzione tra GPT-3.5 e GPT-4 può essere sottile. Le differenze emergono quando la complessità del compito raggiunge una soglia sufficiente: GPT-4 è più affidabile, creativo e in grado di gestire istruzioni molto più sfumate rispetto a GPT-3.5”.

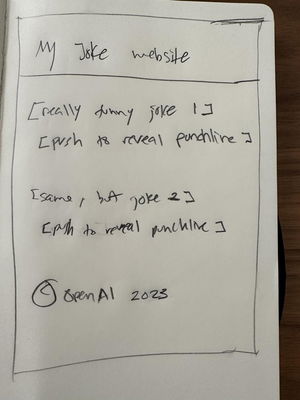

Una novità importante è la capacità di ricevere come input non solo stringhe di testo, ma anche immagini; ha fatto molto scalpore la dimostrazione offerta da Greg Brockman, presidente di OpenAI, che ha disegnato uno schizzo di una pagina Web per poi passarlo al modello che l’ha trasformato in una (semplice) pagina Html completa.

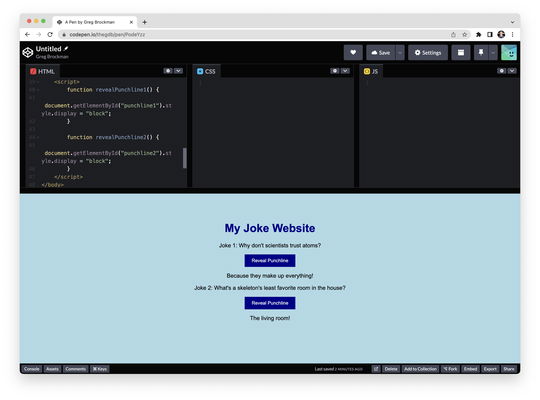

Più interessante per i risvolti pratici è il caso d’uso proposto da Be My Eyes, che ha annunciato un sistema di assistenza per non vedenti e ipovedenti capace di fornire assistenza molto avanzata; l’azienda ha infatti spiegato che il tool potrebbe analizzare la fotografia dell’interno di un frigorifero, individuare tutti gli ingredienti e suggerire cosa cucinare, con istruzioni dettagliate.

Rimanere nei ranghi

Un miglioramento significativo in GPT-4 per l’uso professionale la funzione di “guidabilità” (steerability): attraverso una nuova Api, infatti, gli sviluppatori potranno impostare lo stile e il grado di libertà delle risposte utilizzando indicazioni specifiche.

Nonostante gli aggiornamenti, anche il nuovo modello mostra ancora qualche limite; innanzi tutto, ancora una volta, GPT-4 non conosce gli eventi che si sono svolti dopo settembre 2021, inoltre continua a offrire sporadicamente risposte errate ma verosimili. OpenAI ha comunque sottolineato i miglioramenti rispetto al passato, che riguardano anche la conformità con le policy impostate dall’azienda.

Il nuovo modello è molto più attento a non fornire risposte “non consentite”: secondo l’azienda la capacità di rimanere entro i confini fissati è migliorata del 29% rispetto alla versione precedente.