L’accesso pubblico a ChatGPT ha modificato la percezione dei sistemi automatici di generazione dei testi, trasformando una tecnologia interessante e promettente in un vero e proprio fenomeno di costume.

Il suo successo e le sue potenzialità hanno acceso un dibattito che ha coinvolto diversi ambiti e discipline, dall’educazione alla ricerca accademica, con un’ampia parte dell’opinione pubblica che si è dimostrata preoccupata per le possibili ricadute di un sistema automatico capace di generare testi indistinguibili da quelli originali prodotti dall’uomo.

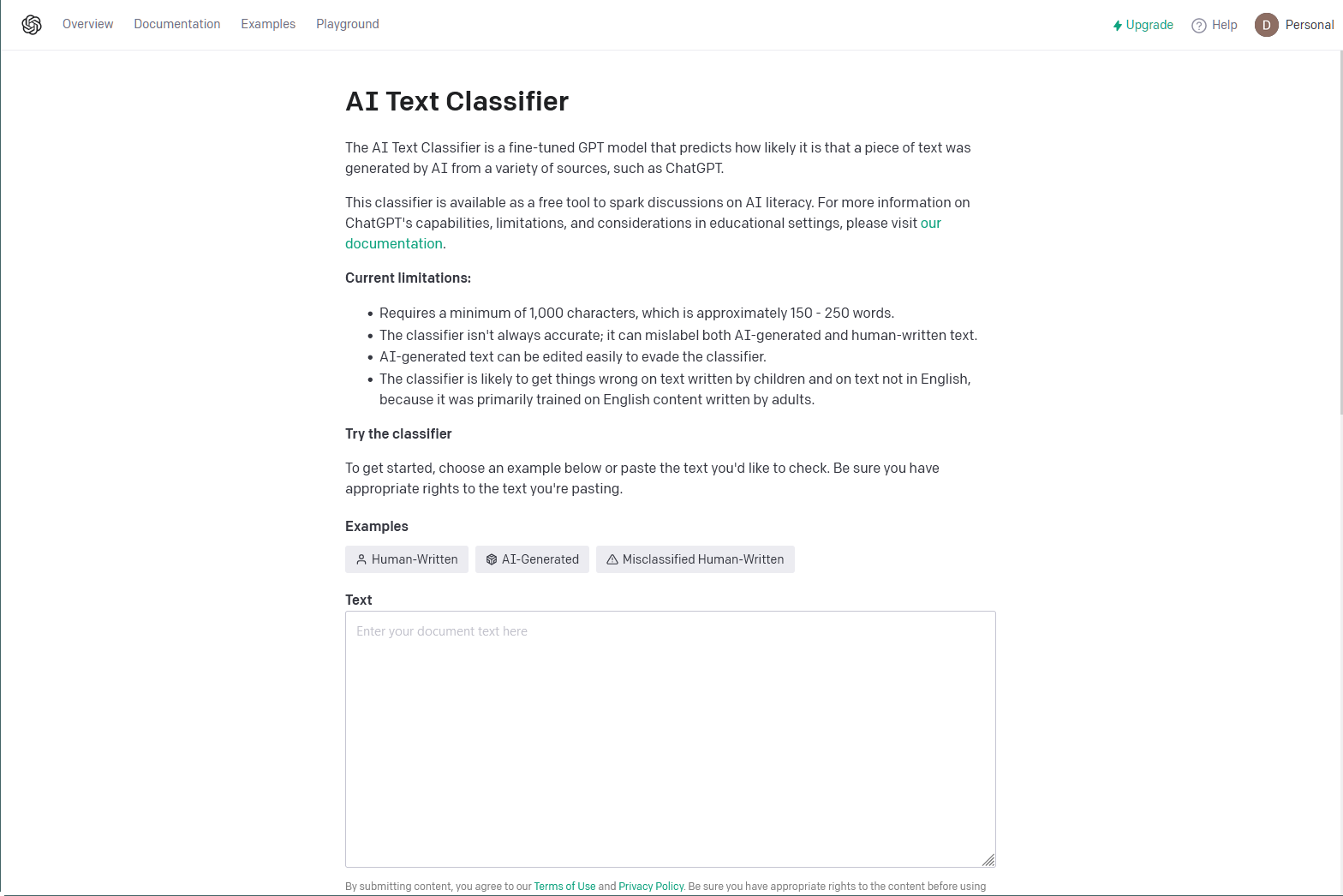

Sono state avanzate diverse proposte per rendere riconoscibili i testi generati dai sistemi basati sull’intelligenza artificiale, e la stessa OpenAI ha tentato di contribuire alla soluzione del problema con il lancio di un sistema di classificazione pensato per dividere i testi generati da quelli “autentici”.

L’azienda ha infatti addestrato un modello di classificazione per distinguere tra testo scritto da un essere umano e testo scritto da IA, non soltanto da ChatGPT ma da un’ampia varietà di soluzioni.

Un primo passo

OpenAI mette immediatamente le mani avanti dichiarando che è impossibile rilevare in modo affidabile tutto il testo scritto dall'IA, ma ritiene che un classificatore ben addestrato possa offrire uno strumento utile per valutare se un testo sia generato dall'IA o scritto da un essere umano.

Il suo scopo è quello di contrastare l'esecuzione di campagne di disinformazione, l'utilizzo di strumenti di intelligenza artificiale per svolgere compiti e progetti accademici o la sostituzione di un essere umano con un chatbot AI.

Nella pagina di presentazione del progetto, OpenAI sottolinea come il classificatore non sia totalmente affidabile: durante le valutazioni interne su un "challenge set" di testi inglesi, il classificatore ha infatti identificato il 26% del testo generati dall'IA come “probabile scritto dall'IA”, senza quindi offrire una catalogazione precisa, mentre invece i falsi positivi sono il 9%.

Anche le analisi compiute da ricercatori esterni immediatamente dopo il rilascio del nuovo strumento confermano la cautela del produttore: nello stato attuale, infatti, il classificatore di OpenAI non sembra essere affatto affidabile.

Lo scopo dichiarato dell’azienda con il lancio di questo modello è ottenere feedback sull’utilità e l’efficacia del tool, ben consapevoli di tutte le sue limitazioni. OpenAI conclude infatti la presentazione dichiarando che il lavoro sul rilevamento del testo generato dall'IA continuerà e che spera di poter offrire strumenti migliori in futuro.