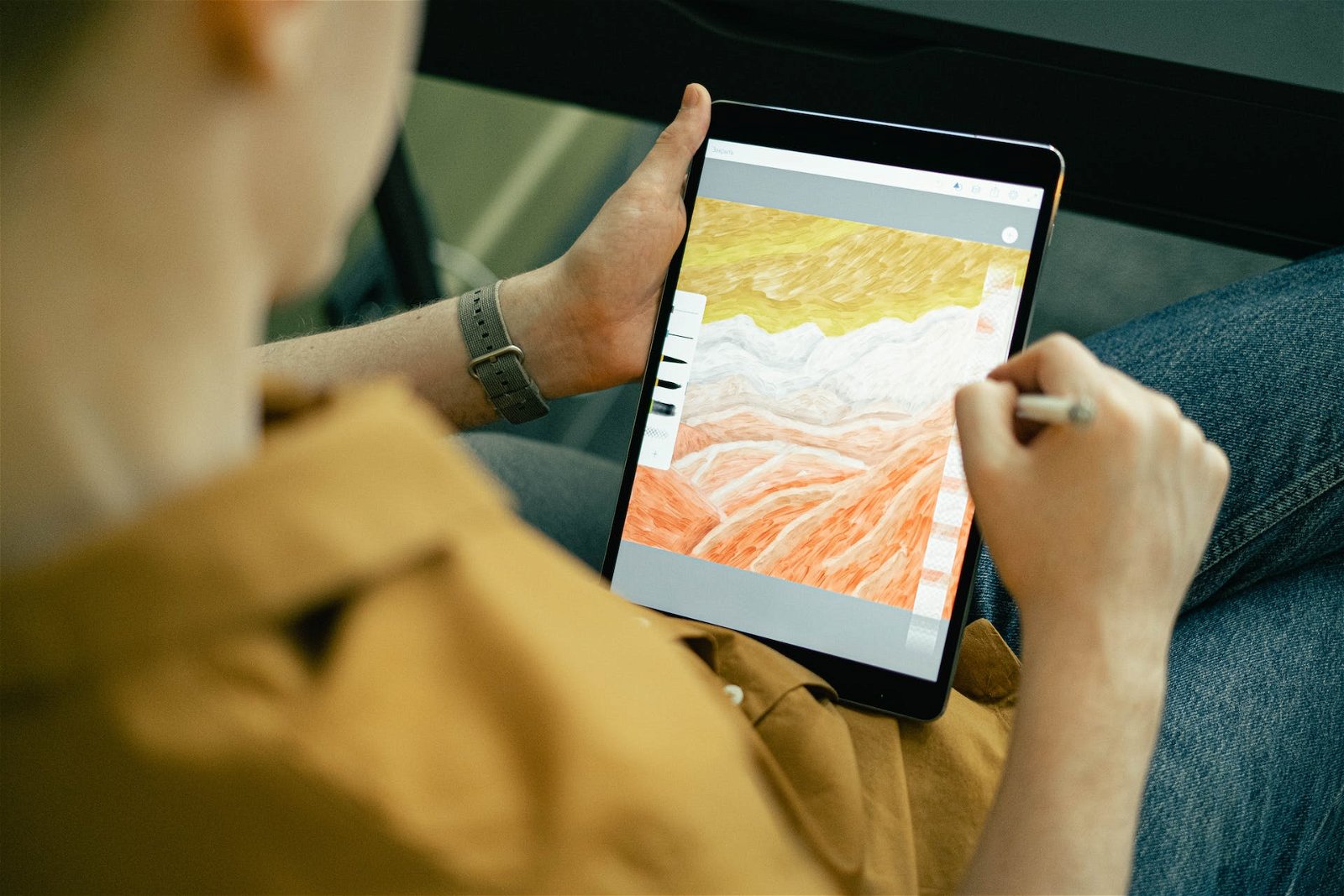

Il web si sta riempiendo di immagini generate con tool di IA e gli artisti continuano a manifestare le proprie preoccupazioni sull'uso delle loro opere nei dataset di addestramento, dal momento che molti non rispettano il diritto d'autore.

Le regolamentazioni in merito sono ancora piuttosto fumose e gli artisti non sono tutelati adeguatamente; per questo l'Università di Chicago ha ideato un tool, "Nightshade", che promette di salvaguardare i diritti delle opere alterandole prima che vengano caricate online e incluse nei dataset di training.

Il nome del tool - "belladonna" in italiano, pianta dai frutti velenosi e potenzialmente fatali - non è stato scelto a caso: Nightshade "avvelena" le opere modificando alcuni pixel per fare in modo che gli algoritmi interpretino immagini, video o audio in modo errato.

"Perché Nightshade? Perché l'asimmetria di potere tra le compagnie di IA e i content owner è ridicola" si legge in un tweet del profilo ufficiale del progetto Glaze, un altro strumento per contrastare il fenomeno dello sfruttamento delle opere senza consenso.

"Sei sei uno studio cinematografico, una compagnia di videogiochi, una galleria d'arte o un artista indipendente l'unica cosa che puoi fare per evitare di essere risucchiato in un modello è 1) iscriversi a una lista opt-out e 2) specificare direttive 'do-not-scrape'".

L'università di Chicago vuole proteggere gli artisti

Le modifiche sono praticamente invisibili a occhio nudo, ma impattano l'analisi dei modelli: per esempio, l'IA potrebbe scambiare un soggetto per un altro a causa dei pixel alterati e produrre qualcosa di totalmente diverso.

Leslie Katz, giornalista e autrice presso Forbes, ha intervistato Ben Zhao, professore a capo del team di sviluppo del tool. Zhao ha spiegato che il sistema "è pensato per chi addestra i modelli senza tenere conto del diritto d'autore, delle liste opt-out e delle direttive do-not-scrape degli artisti".

Il professore ha anche sottolineato che le compagnie etiche, cioè quelle che tengono conto del copyright e delle indicazioni degli artisti, non devono temere Nightshade.

Il tool non è ancora stato rilasciato e non è chiaro come si potranno distinguere gli utenti etici dei modelli da quelli che non rispettano il diritto d'autore: visto che l'opera viene modificata prima di essere caricata sul web, una volta che è stata inserita in un dataset pubblico tutti gli utenti degli strumenti di IA saranno colpiti dal "veleno".

Nightshade può essere efficace se usato solo su dataset privati di aziende o singoli utenti, ma ciò implica l'esecuzione di attacchi di poisoning mirati.

La vera soluzione è sensibilizzare gli utenti dei modelli a collaborare con gli artisti per utilizzare le loro opere rispettandone il copyright e le richieste sui limiti di utilizzo.