Deep Jariwala e Benjamin C. Lee, rispettivamente assistente e professore alla Penn University, hanno condiviso un’analisi sulle sfide a livello infrastrutturale e sui costi nascosti che incidono sull’adozione dei sistemi di analisi e calcolo basati sull’intelligenza artificiale.

La computazione per l'Intelligenza Artificiale prevede tre fasi principali: il pre-processamento dei dati, l'addestramento e l'inferenza dell'AI. Il pre-processamento dei dati consiste nell'organizzare un grande dataset, che potrebbe includere l'etichettatura o la pulizia per creare una struttura.

Una volta pre-processati, i dati possono essere utilizzati per addestrare il modello a interpretarli mediante algoritmi complessi e machine learning. L'inferenza dell'AI prevede l'esecuzione del modello in risposta alle richieste dell'utente, utilizzando dati di grandi dataset per fornire risposte che assomigliano molto a quelle umane.

I grandi modelli di linguaggio come ChatGPT mostrano questo nuovo insieme di operazioni unendo risposte specifiche provenienti da fonti multiple, portando il concetto base di un motore di ricerca a un livello superiore.

Con l'aumento della popolarità dei prodotti di Intelligenza Artificiale come ChatGPT e Bing, la computazione sta diventando sempre più basata sull'inferenza, a differenza dei modelli di machine learning come AlphaGo.

Problemi di scala

Tuttavia, l'integrazione di modelli di IA massicci nelle operazioni quotidiane ha implicazioni significative.

Tutte le attività svolte dai computer sono transazioni tra memoria e processori che richiedono energia. Tuttavia, man mano che queste attività diventano più elaborate e data intensive aumenta l'energia richiesta e la necessità di maggiore spazio di archiviazione.

Secondo la Semiconductor Research Corporation, entro breve la richiesta supererà la quantità globale di storage prodotto ogni anno.

Se l’adozione dell’AI continuerà ai ritmi attuali, è all’orizzonte una crisi energetica, in quanto i computer consumano già oggi il 20%-25% dell'energia globale. Entro il 2040, tutta l'energia prodotta sarà necessaria solo per la computazione, aggravando la crisi energetica attuale.

Inoltre, l'aumento dell'IA ha portato alla costruzione di enormi data center, come quelli di Amazon, Google e Meta, che consumano una quantità significativa di energia e aumentano le emissioni di anidride carbonica.

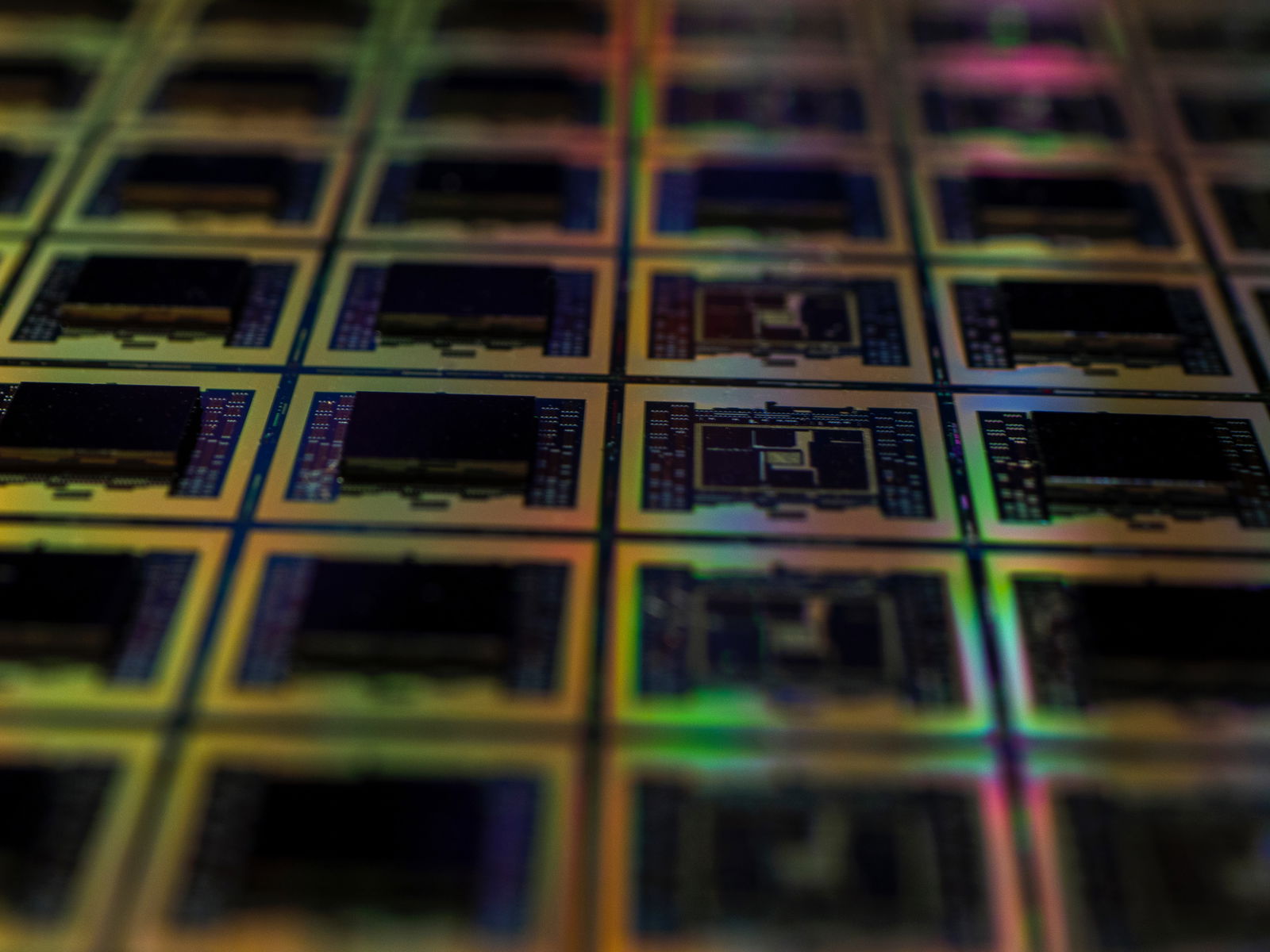

La costruzione di nuove fabbriche per la produzione e l'assemblaggio dei chip necessari per soddisfare la crescente domanda di calcolo sono processi altamente energivori ed esplicitamente costosi dal punto di vista dell’impatto sul clima.