L’annuale evento Google I/O, in cui l’azienda di Mountain View annuncia in genere un gran numero di novità che coinvolgono tutte le principali linee di prodotti e servizi, quest’anno ha visto molti annunci legati al settore dell’intelligenza artificiale.

Di grande prospettiva è il lancio della nuova famiglia di modelli PaLM 2, che rappresentano la base delle funzioni basate sull’IA che Google ha integrato o è sul procinto di integrare in moltissimi servizi. Durante l’I/O, infatti, l’azienda ha annunciato oltre 25 prodotti e funzioni basati su PaLM 2.

PaLM-2

I modelli PaLM 2 sono denominati Gecko, Otter, Bison e Unicorn, e di differenziano tra loro per le dimensioni e il target. Gecko, per esempio, un modello compatto e leggero, al punto da poter essere utilizzato su dispositivi mobili, con una velocità tale da offrire funzioni interattive on-board, senza bisogno di accedere a server remoti.

Secondo le dichiarazioni di Google, i modelli PaLM 2 sono più ferrati nella logica e nel ragionamento, grazie a un addestramento approfondito che ha riguardato argomenti scientifici e matematici. Inoltre, promettono anche una migliore competenza nelle lingue: sono stati addestrati con documenti in oltre 100 lingue, così da poter comprendere e generare testi più ricchi e verosimili.

Le funzioni multilingue promettono di essere il fiore all’occhiello di questa nuova generazione dell’IA di Google; Sundar Pichai, CEO di Alphabet, ha raccontato dal palco dell’evento come il nuovo modello sia in grado non soltanto di correggere in modo esatto un bug all’interno di una porzione di codice, ma possa anche generare il codice commentato in una lingua diversa da quella dello sviluppatore, per semplificare la collaborazione in team di lavoro multinazionali.

Google ha illustrato anche il funzionamento di versioni specializzate dei modelli, come Sec-PaLM 2, specializzata nella sicurezza informatica e capace di spiegare il comportamento del codice malevolo o di aiutare a rilevare eventuali minacce.

Un'altra versione specializzata è Med-PaLM 2, che è stato istruito sulle conoscenze mediche. Secondo Google, questa specializzazione ha migliorato di nove volte la precisione delle inferenze rispetto al modello di base, avvicinandosi al livello di prestazioni offerto da un gruppo di medici esperti, interrogati sulla stessa serie di domande.

Google sta sviluppando nuove funzioni per Med-PaLM 2, al fine di consentire la sintesi di informazioni provenienti da immagini mediche, come lastre e mammografie. L'obiettivo è creare un collaboratore AI per assistere gli specialisti nell'interpretazione delle immagini e nella comunicazione dei risultati.

Quello medico è soltanto uno degli ambienti specialistici che può sfruttare la potenza di PaLM 2; Google si aspetta che questa nuova tecnologia possa essere estesa ad altri settori e per questo ha annunciato la sua disponibilità in anteprima.

La prossima generazione

La famiglia di modelli PaLM 2 è basata sugli sforzi di due team di ricerca di livello assoluto (Brain Team e DeepMind), che Google ha deciso recentemente di riunire in un’unica unità (Google DeepMind) per migliorare le sinergie e velocizzare i progressi.

Da questa integrazione è nato un foundation model di nuova generazione, Gemini, che è ancora in fase di sviluppo. Gemini è stato pensato fin dall’inizio per essere un modello multimodale, altamente efficiente nell’integrazione di strumenti e API ed è stato strutturato per semplificare future innovazioni.

IA responsabile

Oltre a sviluppare modelli di intelligenza artificiale sempre più avanzati, Google ha posto un'enfasi significativa sulla responsabilità dell'AI. Tra le strategie adottate, due approcci cruciali sono il watermarking e l’uso di metadati.

Il watermarking permette di incorporare le informazioni direttamente nel contenuto, assicurando che esse siano mantenute anche in caso di modifiche minori. Per il futuro, Google sta costruendo i propri modelli per includere il watermarking e altre tecniche in modo nativo.

Inoltre, i metadati consentono ai creatori di contenuti di associare ulteriori informazioni ai file originali, fornendo un contesto più ampio. Queste strategie sottolineano l’impegno di Google per garantire che la tecnologia avanzata dell'AI sia utilizzata in modo responsabile e sostenibile.

Funzioni in anteprima

Google ha lanciato una nuova versione della sua tradizionale funzione Labs, che consente agli utenti di accedere in anteprima ad alcune esperienze in Workspace e in altri prodotti, spesso usata in passato in molti dei suoi servizi per fornire un accesso anticipato ad alcuni strumenti e raccogliere feedback dagli utenti.

Attualmente, gli sviluppatori e gli utenti possono già iscriversi per accedere alla piattaforma. Oltre alle funzioni di Workspace, una delle prime esperienze disponibili nei Labs riguarda Google Search.

I miglioramenti nella comprensione del linguaggio naturale consentono di porre domande in modo più semplice e raggiungere i contenuti più rilevanti sul Web. Inoltre, i progressi nella computer vision hanno introdotto nuove modalità di ricerca visiva.

Google Lens consente di effettuare ricerche visuali anche quando non si trovano le parole per descrivere ciò che si sta cercando; le nuove funzioni introducono la multimodalità, che consente di effettuare ricerche utilizzando sia un'immagine che un testo.

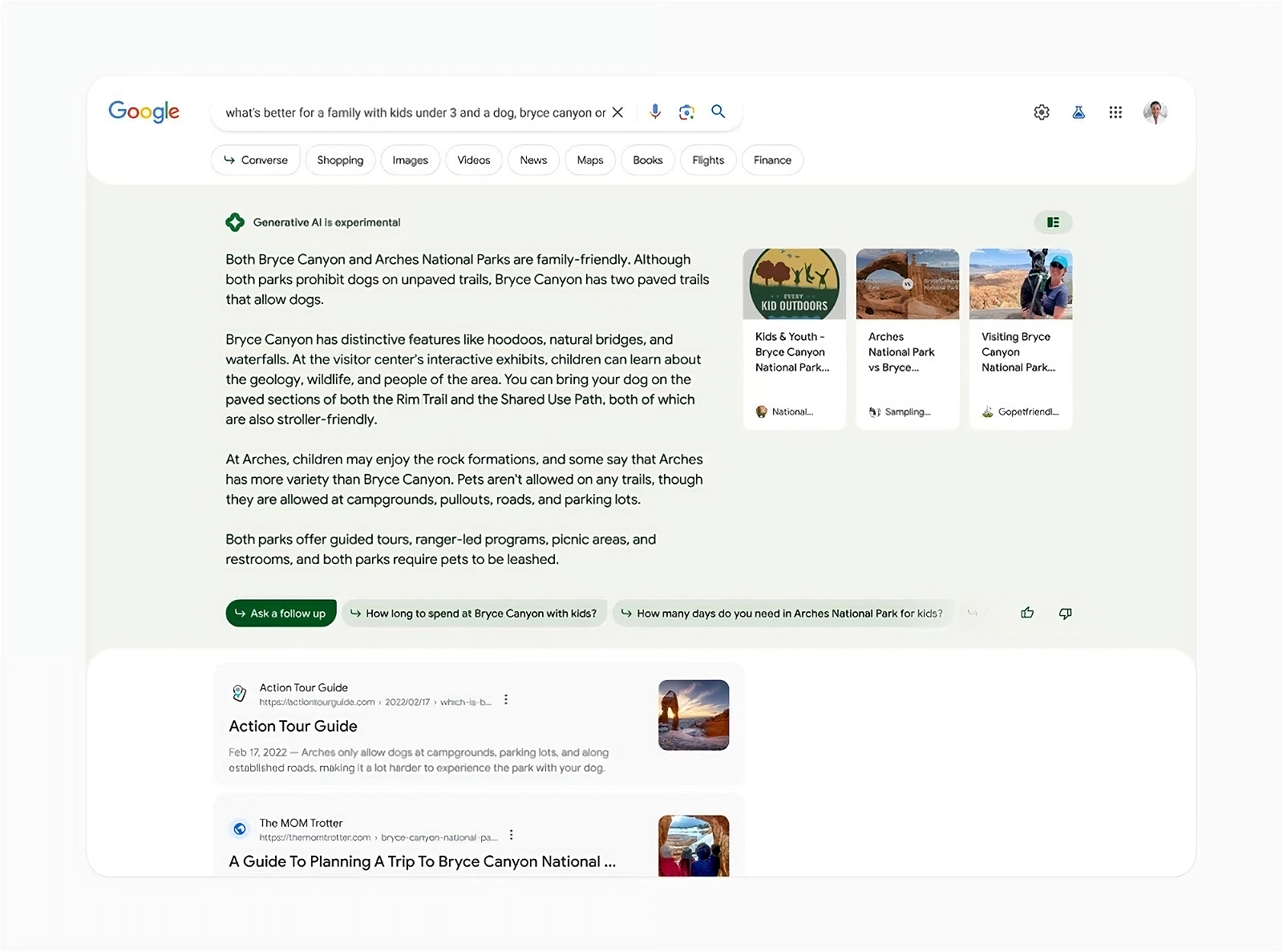

Sulla base di questi concetti Google ha presentato anche la nuova Search Generative Experience, per offrire agli utenti un'esperienza di ricerca completamente nuova, che sfrutta le capacità dell'AI generativa per offrire un ambiente di ricerca più amichevole, coinvolgente e (si spera) anche più efficace.