Ozlem Garibay, professore della University of Central Florida, ha condotto uno studio che ha coinvolto altri ricercatori, per identificare le sfide principali da superare per garantire che l'intelligenza artificiale sia affidabile, sicura e compatibile con i valori umani.

Lo studio, intitolato Six Human-Centered Artificial Intelligence Grand Challenges, è stato pubblicato sull'International Journal of Human-Computer Interaction.

Secondo Garibay, il cui lavoro accademico è dedicato alle applicazioni dell'IA nella progettazione e scoperta di materiali e farmaci e all’influsso di queste tecnologie sui sistemi sociali, l'imminente integrazione diffusa dell'intelligenza artificiale potrebbe avere un impatto significativo sulla vita umana in modi che non sono ancora completamente compresi.

Lo studio, che è stato condotto nell'arco di 20 mesi, comprende le opinioni di 26 esperti internazionali che hanno formazioni diverse nella tecnologia AI; nel loro complesso, queste sfide sono un invito all'azione per la comunità scientifica per sviluppare e implementare tecnologie di intelligenza artificiale che diano priorità e beneficio all'umanità.

Il gruppo di esperti comprende membri della National Academy of Engineering e ricercatori provenienti da Nord America, Europa e Asia che hanno una vasta esperienza nei settori accademico, industriale e governativo. Il gruppo è stato selezionato anche per includere diversi background educativi in settori che vanno dall'informatica e ingegneria alla psicologia e alla medicina.

IA a beneficio dell’umanità

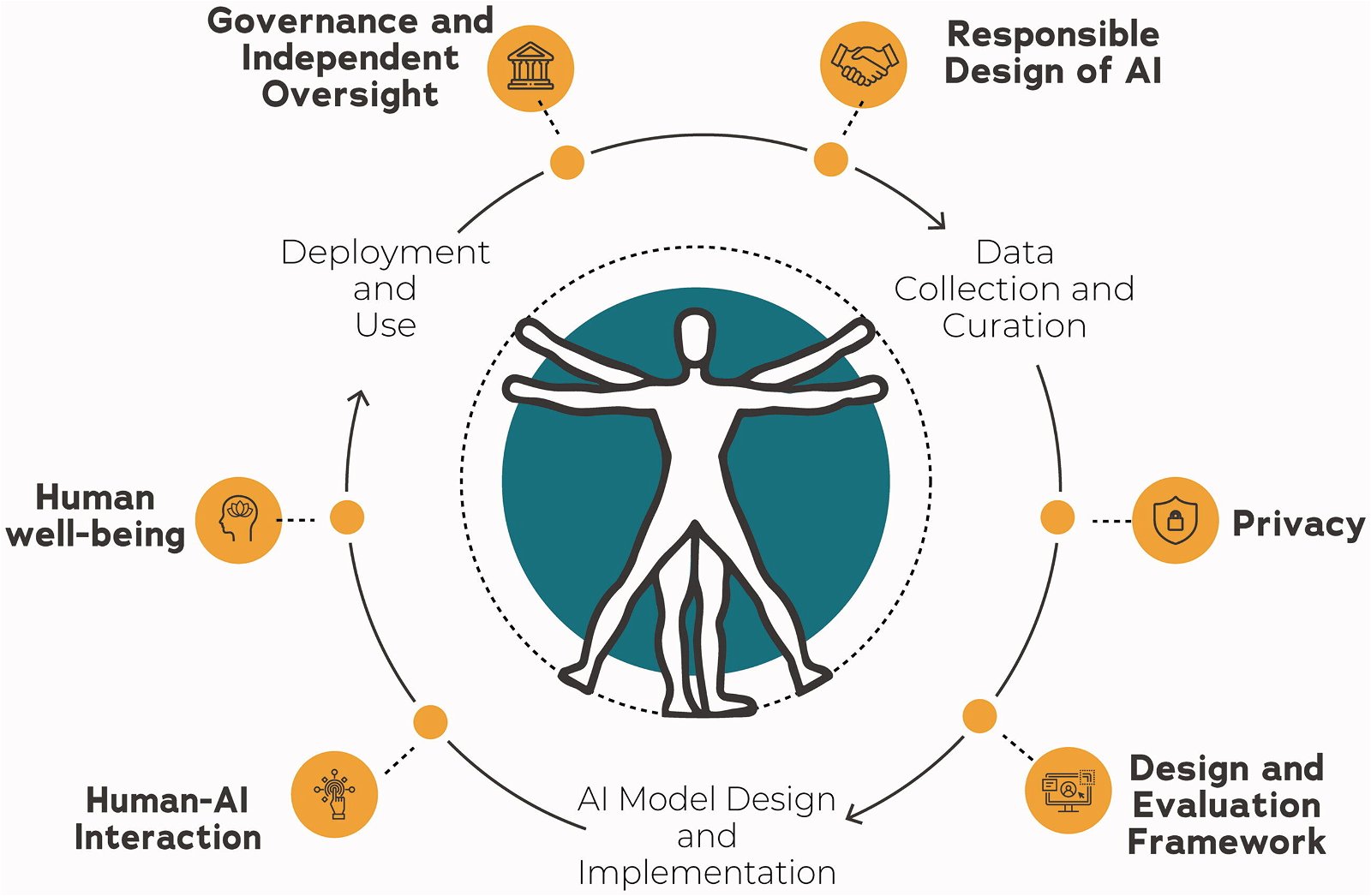

Le sei sfide sintetizzate dal gruppo guidato da Garibay includono temi come il benessere umano, ossia lo sviluppo di un’IA in grado di scoprire le opportunità di implementazione a beneficio degli esseri umani. Dovrebbe anche essere rispettoso nel supportare il benessere dell'utente quando interagisce con l'IA.

L’IA deve anche essere responsabile, ossia dare priorità al benessere umano e sociale attraverso il ciclo di vita dell'IA. Ciò garantisce che i potenziali benefici dell'IA siano sfruttati in modo da allinearsi con i valori e le priorità umane, mitigando al contempo il rischio di conseguenze indesiderate o violazioni etiche.

Grande attenzione è anche stata dedicata al tema della privacy: la raccolta, l'uso e la diffusione dei dati nei sistemi di IA dovrebbero essere attentamente considerati per garantire la protezione della privacy degli individui e prevenire l'uso dannoso contro individui o gruppi.

I principi di progettazione per i sistemi di IA dovrebbero utilizzare un framework in grado di informare i professionisti sui potenziali rischi di adozione. Questo quadro distinguerebbe tra IA con rischio estremamente basso, IA senza misure speciali necessarie, IA con rischi estremamente elevati e IA che non dovrebbe essere consentita.

Secondo gli esperti, è anche necessario un framework di governance e supervisione che consideri l'intero ciclo di vita dell'IA, dall'ideazione, allo sviluppo fino all'implementazione e all’analisi dei risultati.

Infine, per promuovere una relazione etica ed equa tra gli esseri umani e i sistemi di IA, è imperativo che le interazioni siano basate sul principio fondamentale del rispetto delle capacità cognitive degli esseri umani. In particolare, gli esseri umani devono mantenere il controllo completo e la responsabilità per il comportamento e i risultati dei sistemi di intelligenza artificiale.

Garibay ha commentato: “Queste sfide richiedono la creazione di tecnologie di intelligenza artificiale incentrate sull'uomo che diano priorità all'etica, all'equità e al miglioramento del benessere umano”.

“Le sfide richiedono l'adozione di un approccio centrato sull'uomo che includa la progettazione responsabile, la protezione della privacy, l'aderenza ai principi di progettazione centrati sull'uomo, la governance e la supervisione appropriate e l'interazione rispettosa con le capacità cognitive umane”, ha concluso Garibay.